Проверка на санкции яндекса. Как определить фильтры Яндекса? Фильтр за переоптимизацию

Поэтому собственно диагностике Fred-а в книге уделено мало внимания. Как я понял из комментариев читателей, этот вопрос часто вызывает затруднения и путаницу, нужно с ним разобраться.

Изложенные в статье методики достаточно универсальны. Однако акцент будет в основном на два новых вида проблем, с которыми владельцы сайтов столкнулись в 2017 году. По старым знакомым — Пингвину и Панде — материалов в Сети более чем достаточно.

Первая проблема — это комплекс обновлений, которые особенно ярко проявились в феврале и марте. За ними закрепилось неофициальное название Google Fred. Согласно моим исследованиям, Fred опирается общую оценку качества ресурса. Подробно .

Вторая — это сентябрьский апдейт. Его часто приписывают Fred-у; на мой взгляд — совершенно напрасно. В выборке сайтов, которую я изучил, пострадали отдельные страницы с излишней оптимизацией. .

Отправная точка: соотносим время просадки и даты новых алгоритмов

Соотношение «И/П/У/Р»

Изменение посещаемости из поиска на сайте или разделе может вызываться качественно различающимися событиями:

- И счезновение трафика на страницах (был — не стало).

- П оявление трафика на страницах, где его раньше не было.

- У меньшение трафика на страницах (например, из-за ухудшения позиций).

- Р ост трафика на страницах.

На сайте размером от пары сотен страниц практически всегда одновременно наблюдаются все четыре тенденции. Вопрос только в том, какая из них преобладает. По их соотношению можно с достаточно большой уверенностью судить о характере проблем. Подобный анализ актуален для работы под любую поисковую систему.

Несколько примеров.

Разумеется, всегда нужно помнить, что проблема может быть комплексной. Например, комбинация вылета документов из индекса и страничных санкций будет похожа на хостовый фильтр. Важно, однако, что подобный анализ помогает нащупать конкретные болевые точки (например, страницы, где посещаемость снизилась особенно сильно).

Вот реальные данные для сайта, над которым поработал Fred:

Анализ выполнен с помощью инструмента в bez-bubna.com (см. ). Как делать аналогичное вручную я рассказывал на .

Что мы тут видим?

- Страниц, на которых появился трафик, почти два раза меньше чем тех, на которых он исчез.

- Страниц, где посещаемость из Google упала, в 4 с лишним раза больше, чем тех, на которых выросла.

- Общее падение на страницах с частичной потерей дает максимальный вклад в общую просадку.

Картина типична для проблем на уровне всего сайта. Страницам, которые давали трафик по высокочастотным и среднечастотным запросам, сильно срезало позиции. У документов, которые ранжировались по длинному ховосту низкочастотников, уменьшился шанс на попадание в реальную выдачу — поэтому число точек входа тоже упало.

А вот характерный случай санкций на уровне страниц:

Также видим сильное итоговое падение на страницах со снизившимся трафиком. А вот количество точек входа в итоге осталось практически неизменным.

Несложно догадаться, что подобный анализ актуален только на достаточно старых и посещаемых сайтах, где накоплено много статистики.

Собираем дополнительные данные, уточняем диагноз и методы лечения

К этому моменту у нас есть довольно много информации о характере просадки. Наверняка появилась гипотеза о причинах. Теперь нужно отсечь другие возможные объяснения (их бесчисленное множество). Практически всегда полезно:

- Проверить динамику трафика в Яндексе (если она похожа на ту, что в Google — может, дело в сезонности или изменении поискового спроса, а не в санкциях?).

- Изучить историю индексации сайта.

- Проверить, как менялись позиции по наиболее важным ключевым словам (Search Console в помощь).

- Оценить уровень оптимизации под основные запросы на страницах с просевшим трафиком.

Пример рассуждений (для роста трафика, а не падения, но логика аналогична) см. в .

Резюме

- Проблемы с трафиком из Google могут вызывать самые разные причины. Далеко не всегда оно связано с понижением в ранжировании.

- Программа-минимум для достоверной диагностики: определение даты просадки и динамики трафика по разделам, соотношение исчезновения, появления, роста, уменьшения визитов из Google на конкретных страницах.

- Возникшую гипотезу необходимо испытать на прочность с привлечением дополнительных данных. Много ценной информации даст сравнительный анализ статистики по Яндексу и история доработок.

Fred

- Признаки: просадка в один из апдейтов типа «Core Quality», уменьшение количества точек входа (дающее сравнительно небольшой вклад в общее падение посещаемости), сильное снижение трафика на большом количестве страниц; трафик теряют даже высококачественные документы.

- Тактика борьбы: повышение числа полезных документов, удаление или доработка «плохих» страниц. Подробно —

Эта статья будет полезна всем, кто хочет до поискового продвижения сайта убедиться в том, что домен нормальный и с ним не будет проблем в дальнейшем.

Основной метод проверки – это:

— Залить домен на хостинг

— Поставить на него текст + базово прописать мета теги

— Посмотреть как он реагирует

Но в предыдущей статье не указан самый основной нюанс, который с самой высокой вероятностью показывает все ли хорошо с доменом.

Для того чтобы было максимально понятно, рассмотрим на пошаговом примере, как это делаем мы.

Пошаговая инструкция

1. Создаем группу запросов Brand

Обычно это такие ключевики как:

- сайт

- seoprofy

- seo profy

- сайт

Самым важным в этом списке в случае проверки на фильтры является: сайт .

То есть:

- название домена

- убираем точку

- ставим пробел

- добавляем как ключевое слово

- смотрим результаты

В том числе основной ключ для проверки «название домена, без точки, с пробелом».

Пример зафильтрованного домена:

Сразу видно что с доменом что-то не так.

2. Получаем ответ

Основной критерий : сайт не находиться в ТОП 1.

В большинстве случаев если домен не находиться в топ 1 по такому запросу, то либо санкции за обратные ссылки, либо еще за что-то.

Важно : но в консоли Google, в разделе «Меры, принятые в ручную» может ничего и не быть (фильтр может быть автоматический).

Но, из 99% случаев, когда слетает этот запрос, то домен ушел под фильтр. Тоже самое, когда только запускается домен заглушка.

3. Кому это полезно?

- Те, кто регистрируют дроп домены для сателлитов под трафик

- Те, кто покупают сайты или домены под проекты

По сути, если сайт находиться в индексе, мы проверяем это за пару минут, в итоге сразу понятно, все ли с ним нормально или нет.

В заключение

В данном методе нет ничего сложного. Можно проверять как руками сразу в Google, так и через сервисы проверки.

Метод простой, как конструкция лома. Но по факту, это быстро, и сразу показывает нужно ли детально анализировать домен на предмет санкций.

Для закрепления, визуально:

Используйте этот простой метод, и сразу принимайте решения, стоит ли тратить время на такой домен или нет.

А что вы думаете по этому поводу? Давайте обсудим в комментариях!

Инструмент поможет определить, присутствуют ли санкции в виде фильтра “переспам”, которые наложила поисковая система Яндекс на сайт по указанному запросу. Диагностика наличия фильтра даст понимание ситуации, появится ответ на вопрос “почему позиции сайта не растут по самому частотному запросу?”.

За что можно получить фильтр "Переспам" от Яндекса?

Название "переспам" говорит само за себя. Чаще всего данный фильтр можно получить именно из-за избыточного количества точных вхождений запроса на странице, которое требуется снизить. Также рекомендуем проверить значение alt и title у картинок, возможно, запрос использован и там. Еще рекомендуем проверить входящие внутренние и внешние ссылки на страницу; если запрос слишком часто использовался в виде анкора, это тоже может послужить поводом для санкций.

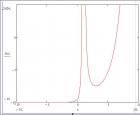

Главной отличительной особенностью этого фильтра является его запросозависимость. Это означает, что при модификации проверяемого запроса позиции должны быть лучше на 20-40 позиций, что и является основой инструмента, умеющего определять

Поисковые системы "чистят" интернет-пространство от некачественных, использующих "черные" приемы СЕО-продвижения сайтов. С этой целью время от времени вводятся новые алгоритмы поисковых систем, каждый из которых направлен на определенное нарушение. Далее к сайту применяются санкции, ограничивающие его работу.

Своевременная диагностика и вывод из-под фильтра поможет сохранить работоспособность сайта и прибыль его владельца.

Как узнать, что сайт попал под фильтр

Признаками подпадания сайта под фильтр являются:

Как проверить фильтры поисковиков

Существуют специальные инструменты веб-аналитики, благодаря которым можно подтвердить догадки о наложении фильтра:

- число страниц в индексе поисковых систем можно проверить через Яндекс.Вебмастер или Search Console Google;

- посмотреть изменения в трафике после обновлений алгоритмов Яндекса и Google можно посредством инструмента "Диагностика санкций SEOLib", у Google — инструмент Fruition;

- вероятность наложения фильтров на сайт, не использующих системы аналитики, возможно узнать, воспользовавшись сервисом FEInternational.

Виды фильтров

Выделяют несколько классификаций фильтров:

1. По поисковой системе, к которой они относятся, выделяют фильтры Яндекс и Google.

2. По причине наложения фильтра различают:

- фильтры за техническое несоответствие ресурса: неадаптированные ресурсы, отсутствие полезного контента, дублирование содержимого, мошенничество, медленная загрузка страниц, некачественный дизайн, низкий уровень функционала;

- фильтры, налагаемые за манипуляцию выдачи: накрутка поведенческих факторов, переспам ключевиков в тексте, большая ссылочная масса.

3. По способу включения:

- ручные — включаются сотрудником поисковых систем после фиксации нарушения роботом, этот вариант возможен при подозрении на нарушение, вердикт о наложении фильтра выносит человек;

- алгоритмические — включаются машинами при явном нарушении, зафиксированном роботами поисковых систем.

Фильтры Яндекса

С определенного времени Яндекс не учитывает внешние ссылки при "распределении" позиций выдачи. Но у него есть другие методы выявления недобропорядочных оптимизаторов. Теперь он сосредоточил свое внимание на попытках накрутки поведенческих факторов.

- АГС — самый известный фильтр Яндекса. Используется для борьбы с некачественными сайтами.

Некачественность сайта

определяется по следующим критериям:

Некачественность сайта

определяется по следующим критериям:

- неуникальные тексты;

- проблемы с функционалом, дизайном;

- наличие исходящих ссылок;

- реклама агрессивного характера, дубликаты страниц, клоакинг;

- неуникальные описания страниц.

Наложение на сайт этого фильтра можно определить по следующим признакам:

- не происходит индексация новых страниц;

- количество посетителей снижается;

- большая часть страниц выпадает из индекса.

Для восстановления сайта после воздействия на него фильтра АГС необходимо принять следующие меры:

- привести сайт в соответствие требованиям;

- удалить все СЕО-ссылки;

- начать регулярно выкладывать на сайт только уникальные тексты;

- пересмотреть навигацию;

- удалить агрессивную рекламу.

Вывод сайта из-под АГС может занять до нескольких месяцев.

Фильтр за переоптимизацию

Под этот фильтр попадают сайты, занимающиеся выкладкой текстов с переспамом ключевых слов.

Что нужно делать, чтобы избежать "наказания" Яндекса:

- тексты должны создаваться для людей, а не для роботов;

- не нужно выделять ключи тегами.

Фильтр за накрутку поведенческих метрик

Фильтр за накрутку поведенческих метрик выявляет сайты, пользующиеся услугами сервисов эмуляции действий посетителей ресурса.

Обычно наложение данного фильтра проявляется следующим образом:

Обычно наложение данного фильтра проявляется следующим образом:

- трафик снижается;

- позиция сайта в поисковой выдаче падает;

- новые страницы очень медленно индексируются системой.

Чтобы снять данный фильтр, нужно перестать манипулировать поисковой выдачей.

«Минусинск»

Этот фильтр накладывается поисковой системой Яндекс за превышение ссылочной массы.

Идентифицировать действие фильтра можно по нескольким признакам:

- падение трафика;

- отсутствие сайта на первой странице поиска при запросе по доменному имени;

- "уход" на несколько позиций вниз в выдаче.

Чтобы снять с сайта данный фильтр, придется удалить все входящие ссылки манипулятивного характера.

Фильтр аффилиатов

Наложением фильтра аффилиатов Яндекс "отмечает" сайты, имеющие три и более сайта, привлекающих клиентов в одну и ту же организацию. Яндекс этого не одобряет. Занимаются места в поисковой выдаче, которые могли бы занять другие организации.

Единственный признак, по которому можно определить действие данного фильтра — присутствие в поисковой выдаче Яндекса одного-единственного сайта из всех созданных. При этом Яндекс не спрашивает, какой из этих ресурсов приносит большую прибыль, и выбрать наиболее ценный, чтобы оставить его в выдаче, не получится.

Избежать меры воздействия можно при условии создания сайтов, имеющих контакты одной фирмы, с предложением разных продуктов, тогда посетители будут переходить на эти сайты по разным поисковым запросам, и поисковую систему это вполне устроит.

Непот-фильтр

Поисковая система не признает, что этот вид фильтра существует. Но среди владельцев сайтов "ходят" догадки о наличии алгоритма, блокирующего передачу ссылок и приостанавливающего работу сайта.

Обезопасить себя от непот-фильтра возможно 2 способами:

- не торговать ссылками;

- при вставке ссылки на сомнительного рода источник, прятать линк под атрибутом nofollow.

Фильтр за adult-контент

При обнаружении Яндексом наличия на сайте материалов "для взрослых" им будет наложено табу на трафик сайта по запросам, отличным от "взрослых".

Здесь метод стар и прост как мир — не нужно использовать adult-контент на своем сайте.

Фильтр за дорвеи

Наличие дорвеев обычно приводит к исключению сайта из выдачи поисковой системы.

Оптимальный способ защиты сайта от наложения фильтра — не использовать дорвеи.

Фильтры Google

Фильтры Google также направлены на повышение качества сайтов, возможности молодых "хороших" сайтов занимать верхние позиции выдачи, борьбу с нарушителями.

«Панда»

Этот вид фильтра уменьшает количество посетителей некачественных ресурсов

с целью посещения ими сайтов качественных.

Этот вид фильтра уменьшает количество посетителей некачественных ресурсов

с целью посещения ими сайтов качественных.

За качественные принимаются ресурсы, отвечающие нескольким критериям:

- Качество содержимого сайта.

- Отношение к посетителям сайта, проявляющееся в уровне функционального удобства, юзабилити, дизайна.

- Отсутствие чужого и дублирующего контента.

Определить, что сайт попал под фильтр "Панда", можно по следующим признакам:

- падение трафика;

- снижение позиций в выдаче, могут изменяться позиции всех или нескольких страниц ресурса, возможно выпадение некоторых страниц в дополнительный индекс;

- медленное индексирование страниц.

Изменение стратегии маркетинга поможет преодолеет барьеры, возникшие в результате наложения фильтра. Особое внимание нужно уделить:

- Контенту. Он должен быть полезным аудитории, достаточного объема. Его необходимо регулярно обновлять. Сайт не должен содержать страниц без текста и страниц-дубликатов.

- Корректировке технических характеристик сайта.

«Пингвин»

Алгоритм "Пингвин" был внедрен с целью борьбы с избыточной ссылочной массой:

- спамом;

- публикацией ссылок, не видимых посетителю сайта;

- ссылками на сторонних ресурсах;

- покупкой бэклинков.

"Опознать" данный фильтр можно по следующим признакам:

"Опознать" данный фильтр можно по следующим признакам:

- медленная индексация новых страниц;

- выпадение некоторых страниц в дополнительный индекс;

- снижение сайта в позициях поисковой выдачи;

- резкое уменьшение количества посетителей сайта.

Google выдает сообщение о принятых специалистами системы мерах, связанных с большим количеством ссылок.

Вывести ресурс из-под фильтра "Пингвин" поможет удаление и/или отклонение некачественных ссылок на сайт, публикация информативного уникального контента. ля обнуления веса ссылок можно воспользоваться специальным инструментом отклонения.

«Песочница» и «Возраст домена»

Это, скорее, части алгоритма, накладывающие ограничения по скорости индексации на недавно созданные сайты. На них можно не обращать особого внимания, заниматься развитием сайта в плане его качества, удобства и информативности для пользователя. Постепенно сайт выйдет из-под действия данных фильтров.

-5, -30, -950

Снижение позиции выдачи на 5, 30 пунктов, снижение позиции до 9 сотни выдачи оптимизаторы называют фильтрами -5, -30 и -950 соответственно, хотя официальных подтверждений существования таких алгоритмов от Google нет до сих пор.

Такие фильтры "поисковик" накладывает на сайты, нарушающие тех. требования, и использующие манипулятивные техники в привлечении посетителей:

- спам посредством размещения ссылок в блогах и на форумах;

- методы продвижения посредством дорвеев и клоакинга;

- неинтересный текст, пресыщенный ключевыми словами.

Снятие фильтров и возврат к прежним позициям в выдаче возможны после устранения нарушений требований Google и переиндексации сайта.

Дополнительные результаты

"Поисковик " может поместить страницы сайта в дополнительный индекс:

"Поисковик " может поместить страницы сайта в дополнительный индекс:

- если "считает" страницы неинтересными, неуникальными, похожими на многие другие по данной теме;

- если они имеют ошибки в техническом исполнении или происходит манипуляция выдачи;

- если сайт совсем "молодой".

Признак здесь один, он очевиден — ранжирование страниц не в основном, а в дополнительном индексе.

Чтобы вывести сайт из доп.индекса, необходимо вывести сайт на уровень технических требований поисковой системы, начать публиковать информативный актуальный контент, не манипулировать выдачей.

«Социтирование»

При возникновении такой проблемы нужно удалить либо обнулить вес подобных ссылок на сайт. Если становится очевидным, что это "происки конкурентов", можно сообщить о ситуации в тех.поддержку Google.

«Слишком много ссылок и страниц»

Слишком много ссылок на сайт на сторонних ресурсах либо выкладка большого числа страниц может вызвать такие последствия, как снижение позиции в выдаче и, как следствие, снижение посещаемости сайта.

Для предупреждения такого развития событий нужно отказаться от внешних ссылок, а страницы выкладывать постепенно.

Фильтр за битые ссылки

Для того, чтобы предотвратить меры воздействия системы поиска, необходимо регулярно проверять сайт инструментом Link Checker и исправлять обнаруженные битые ссылки.

Сайты, считающие возможным копирование контента с других ресурсов, могут попасть под действие фильтра, что повлечет за собой исключение сайта полностью или части его страниц из поисковой выдачи.

После удаления чужих текстов с сайта либо указания ссылок на первоисточник нужно начать заполнять сайт уникальными материалами.

Фильтр за переоптимизацию

Наложение системой фильтра за переоптимизацию происходит, если сайт манипулирует выдачей:

Наложение системой фильтра за переоптимизацию происходит, если сайт манипулирует выдачей:

- в текстах избыточное количество ключевых слов;

- ключевые фразы выделены полужирным или цветным шрифтом.

Признаком действия ограничения системы является снижение позиции сайта в выдаче.

Для снятия фильтра необходимо отказаться от манипуляций и начать создавать материалы на сайт для людей, а не для поисковых систем.

Фильтр за медленную загрузку страниц

Если страницы сайта загружаются медленно, это не удовлетворяет посетителей сайта. Такие ресурсы Google обычно лишает трафика. Происходит это посредством снижения позиции сайта в общей выдаче, либо в мобильной выдаче.

Увеличение скорости загрузки сайта исправит сложившуюся ситуацию.

Фильтр за отсутствие оптимизации под мобильный трафик

Отсутствие адаптивной верстки тоже сказывается не лучшим образом на продвижении сайта. Признаком наложения данного фильтра будет падение позиций сайта в мобильной выдаче, при этом позиции в выдаче общей сохранятся на прежнем уровне.

Чтобы такой проблемы не возникло, специалисты рекомендуют изначально делать сайт адаптивного дизайна.

Чек-лист по фильтрам

| Причины подпадания под фильтр | Фильтры «Яндекс» | Фильтры Google | Как вывести сайт из-под фильтра |

| Минусинск | Удаление некачественных ссылок, отклонение ссылок специальным инструментом Google |

||

| Заимствование чужого контента, неуникальные тексты | Фильтр за дубликаты страниц | Фильтр за дублированный контент Дополнительные результаты | Снятие неуникальных текстов, создание качественного контента |

| Низкая функциональность, плохой дизайн, неудобная навигация | Дополнительные результаты | Корректировка сайта для большего удобства и комфорта пользователя |

|

| Переспам по "ключам" | Фильтр за переоптимизацию | Начать делать упор не на SEO-приемы, а на информативность и актуальность текстов |

|

| Несоответствие тех.требованиям поисковой системы | Фильтр за некорректные мобильные редиректы | Отсутствие оптимизации под мобильный трафик | Приведение сайта в соответствие требованиям «поисковиков». |

| Продажа ссылок | Непот-фильтр | Прекратить продажи ссылок |

|

| Клоакинг, спам на форумах, дорвеи. | Минусинск | Не использовать эти методы |

|

| Изменения в трафике по неизвестным причинам | Минусинск | Если виноваты конкуренты, просить помощи у службы поддержки "поисковика" |

Фильтры на самом деле не только не страшны, но и полезны, особенно если ориентироваться на них как на результат бесплатного аудита сайта поисковыми системами. Лучший способ действий — выявить, исправить и продолжать работать еще эффективнее!

С уважением, Настя ЧеховаНет ни одного сайта, который бы был застрахован от фильтров поисковых систем (за некоторыми исключениями вроде Википедии). Даже крупный, белый и пушистый сайт может попасть под фильтры, это может быть следствием ошибки алгоритмов или по другим причинам (взлом, вирусы), но не застрахован никто. Для хорошего сайта вероятность попасть под фильтр крайне мала, а если на них накладывают ошибочные санкции, то их обычно довольно быстро снимают по запросу в службу поддержки.

Фильтры придумали не просто так, они выполняют ряд задач, которые можно условно разделить на две группы:

- Наказание сайтов за несоблюдение рекомендаций поисковых систем и попытки манипулирования выдачей;

- Освобождение вычислительных ресурсов поисковых систем . Это бывает тогда, когда сайт настолько плох, что его даже не стоит индексировать.

Подавляющее большинство фильтров относится к первой группе, ко второй группе относится фильтр Яндекса АГС, у Google есть дополнительные результаты выдачи (подробности ниже), также он может не индексировать сайты или отдельные страницы, которые считает слишком плохими.

Признаки и последствия фильтров

Признаки у фильтров поисковых систем бывают следующие:

- Сокращение поискового трафика;

- Снижение всех или большой группы позиций в выдаче (единовременное);

- Впадение сайта из индекса или отдельных страниц;

- Новые страницы перестают индексироваться;

- Сайт находится не на первых местах в выдаче по витальным запросам;

- Ряд других признаков, о которых я расскажу в описании фильтров.

Соответственно, при любой причине вас ждет частичная или полная потеря естественного поискового трафика. Это главное последствие для коммерческих сайтов. Любые негативные изменения могут быть признаком фильтра от поисковой системы и должны быть причиной проверки наличия возможных санкций.

Стоит ли бояться фильтров поисковых систем?

Если вы делаете хороший сайт, на котором все правильно, то в этом случае бояться не стоит. За незначительные ошибки фильтры на вас не наложат, а если вы все же попадете под санкции, то обычно это можно легко исправить, правда, в некоторых случаях это может занять длительное время. Если алгоритмы ошиблись и вас наказали ошибочно, то здесь исправить все можно гораздо быстрее.

Подумайте еще и о том, что фильтры защищают вас от тех, кто не готов к честной и конкурентной борьбе за позиции в поисковых системах, а пытается выехать на попытках манипулировать факторами, которые влияют на позиции в выдаче. Кстати, у поисковиков тут есть и своя логика. Их полностью устраивает ситуация, когда продвижение сайта становится все сложнее и дороже, ведь они ждут вас в Яндекс Директе или Google AdWords .

Фильтры Яндекса

Самый известный и один из самых старых фильтров отечественного поисковика. Первая версия называлась АГС-17, последняя – АГС-2015 (неофициальное название, сам Яндекс номер ему не присвоил).

Главная задача этого фильтра – убирать из выдачи плохие сайты. Признак первых версий АГС – полное выпадение сайта из индекса, иногда могло остаться лишь несколько страниц. АГС накладывают за:

- Неуникальный и некачественный контент;

- Большое количество исходящих SEO-ссылок;

- Технические проблемы (дубли, клоакинг);

- Большое количество рекламы, плохой дизайн.

Результат – практически полная потеря трафика из поиска Яндекса. За некоторые факторы по отдельности Яндекс может и не наложить АГС, но вот если их несколько, то риск очень велик. Например, на сайте много SEO-ссылок, но при этом на нем хорошие поведенческие факторы, контент хороший, технических и других проблем нет. В этом случае сайт может и не попасть под фильтр. Так было до 2015.

В 2015 Яндекс обновил АГС и теперь он может наказать даже очень хороший сайт за торговлю SEO-ссылками. Здесь признаком будет обнуление ТИц, страницы при этом останутся в выдаче, однако сайт может потерять часть трафика. То есть, это альтернативная версия АГС, более мягкая. Вот пример трафика на сайте, который ненадолго попал под АГС осенью 2015:

Очень хорошо виден провал по количеству посетителей. После того, как часть ссылок была снята, трафик восстановился, хотя и в несколько меньшем объеме.

Если ваш сайт попал под АГС-2015 и вам обнулили ТИц, то единственным решением будет снятие SEO-ссылок (как минимум части). На сайте должна накопиться определенная критическая масса ссылок, после чего его и наказывают. Алгоритм расчета неизвестен, но очевидно, что для каждого сайта количество SEO-ссылок определяется индивидуально.

Когда из индекса вылетают страницы вашего сайта, одними ссылками уже не ограничится. Обратите внимание на все факторы, которые могли привести к АГС. Устраните все проблемы, если найти их не получается, обратитесь к специалистам для проведения аудита. Для ускорения выхода из под АГС можно написать в службу поддержки Яндекса, но писать нужно тогда, когда вы точно уверены, что с сайтом все хорошо.

Минусинск

Появился в 2015 году, наказывает сайты за внешние SEO-ссылки. Признаки следующие:

- Резкое снижение позиций в выдаче и падение трафика;

- Сайта нет на первой странице выдачи по витальным запросам.

Главная причина попадания под Минусинск – ссылки с плохих сайтов и спамные анкоры. Никто точно не знает, сколько нужно таких ссылок, известны случаи, когда под этот фильтр попадали сайты с десятками тысяч, а были и такие, кого наказывали за несколько сотен.

Снять Минусинск можно единственным способом – снизить количество или полностью убрать внешние ссылки. Как минимум нужно убрать самые плохие, с сайтов под АГС и со спамными анкорами. К сожалению, Яндекс не дает никаких инструментов (как это делает Google), поэтому если вы покупали вечные ссылки, вам придется договариваться с владельцами площадок об их снятие. В биржах GoGetLinks и Miralinks после выхода Минусинска сделали возможность отправлять заявки на удаление ссылок.

Накрутка поведенческих

Как только оптимизаторы достоверно узнали, что поведенческие факторы могут очень сильно влиять на позиции, появились сервисы, которые обеспечивали их накрутку. Яндекс смотреть на подобные манипуляции не стал, усовершенствовал фильтр, который уже существовал, а также ужесточил наказание. Признаки такие:

- Резкое падение позиций и трафика;

- Новые страницы медленно входят в индекс.

Выйти из под фильтра за накрутку поведенческих факторов в Яндексе можно только полностью прекратив эти манипуляции. Яндекс сам выпустит вас из под этого фильтра, но ждать можно несколько месяцев. Я рекомендую отказаться от попыток накрутки поведенческих факторов, иначе наказание от Яндекса будет неизбежным.

Аффилиаты

Фильтр создан для борьбы с компаниями, которые делают несколько сайтов и пытаются захватить все первые места в поисковой выдаче. Признак этого фильтра всего один и очень яркий: в выдаче останется только один сайт. Яндекс определяет аффилиаты по одинаковым контактным данным, по схожей тематике (контенту) и данным в WHOIS (если они не скрыты). Он учитывает и структуру сайтов, IP, на котором они расположены, CMS и другие мелочи, которые могут указать на одного владельца разных сайтов.

Выйти из под этого фильтра можно только в том случае, если вы смените все данные, по которым Яндекс может определить аффилиаты и напишете в службу поддержки.

Взрослый контент

Если Яндекс решит, что на вашем сайте есть взрослый контент, он полностью исключит его из выдачи по запросам, которые не относятся к этой тематике. Чаще всего причиной является банальный взлом сайта, после которого на него заливают страницы с подобным контентом. Как только вы увидели, что на ваш сайт идут по запросам 18+, нужно срочно найти и устранить причину, не дожидаясь фильтра.

Непот-фильтр

Яндекс так и не признал существование этого фильтра, однако практически все оптимизаторы склоняются к тому, что он существуют. Его накладывают на сайты, которые слишком активно торгуют ссылками. После наложения непот-фильтра, ссылки с таких сайтов перестают учитываться. Вполне возможно, что сегодня его заменил АГС-2015, который обнуляет ТИц, что ясно сигнализирует о том, что сайт наказан именно за ссылкоторговлю.

Фильтр за переоптимизацию

Яндекс накажет вас за попытки манипулировать выдачей с помощью слишком большого количества ключевых фраз. В отличие от АГС, этот фильтр оставит страницы сайта в индексе, но вот высокие позиции они не получат, соответственно не будет и трафика. Точного процента ключевых слов в тексте, за который Яндекс может вас наказать, назвать нельзя, это определяется индивидуально, но стоит избегать слишком большого количества ключей, особенно неестественных. Не стоит злоупотреблять ключевыми словами в заголовках.

Фильтр за шок-рекламу

В зоне риска оказываются сайты, которые для монетизации использую тизерные сети, в которых часто бывают объявления с так называемым шок-контентом. Подобные сайты понижают в выдаче, избавиться от этого фильтра можно, если убрать плохую рекламу.

В бета-версии Яндекс Вебмастера появился раздел, в котором можно посмотреть наложенные санкции:

Фильтры Google

Penguin (Пингвин)

Пингвин от Google – фильтр за манипуляцию внешней ссылочной массой, Минусинск от Яндекса является как раз аналогом Пингвина. Наказание следует за большое количество ссылок с некачественных ресурсов, за невидимые ссылки и за спамные конструкции в анкорах. Признаки следующие:

- Снижение позиций и трафика;

- Новые страницы индексируются медленно;

- Часть страниц могут попасть в дополнительный индекс;

- Информация о мерах принятых вручную в Google Search Console.

Google сообщает о выходе очередной версии Пингвина, обычно об этом в своем Твиттере пишет этот сотрудник компании, информацию можно узнать и на SEO-форумах. Если на ваш сайт трафик стал резко снижаться как раз во время обновления Пингвина, то можно быть уверенным на сто процентов, что вы попали именно под этот фильтр.

Принцип выхода из под этого фильтра точно такой же, как и в случае с Минусинском Яндекса, вам нужно удалить плохие ссылки. Но у Google есть удобный инструмент, который позволяет отклонять нежелательные ссылки, найти его можно по этой ссылке . В отдельных случаях этого инструмента будет недостаточно и все равно придется удалять нежелательные ссылки. Об этом вас сообщат в ответе на запрос на пересмотр сайта.

Panda (Панда)

Этот фильтр наказывает за внутреннюю оптимизацию, то есть, он оценивает сайт в целом. Причины могут быть следующими:

- Контент очень низкого качества или ворованный;

- Наличие дублей страниц;

- Плохие поведенческие факторы;

- Большое количество рекламы;

- Проблемы с дизайном, юзабилити.

Признаков может быть несколько:

- Падение трафика из поиска Google;

- Падение позиций, важно знать, что этот фильтр могут наложить на часть сайта, а могут и на весь;

- Новые страницы индексируются медленно.

По аналогии с Пингвином, о выходе каждой новой версии Панды сообщают сотрудники Google.

Рекомендация по выходу из под Панды только одна. Нужно провести серьезную проверку сайта и устранить все проблемы, которые могли стать причиной фильтра. Обратите внимание на качество контента, убедитесь, что нет переспама ключевыми фразами, грамматических ошибок, проанализируйте поведенческие факторы. Плохие ПФ обычно как раз и сигнализируют о плохом качестве ресурса.

Дополнительные результаты

У Google есть supplementaly results – дополнительные результаты, которые на жаргоне оптимизаторов называют «сопли». Туда попадают страницы, которые Google не считает ценными, но все равно проиндексировал их. Дополнительные результаты будут доступны для пользователя, только если он кликнет на «Показать скрытые результаты» в самом низу страницы. Разумеется, ждать трафика на страницы, которые попали в supplementaly results не стоит.

Что бы избежать попадания страниц в дополнительные результаты, размещаете только хороший и интересный контент, не злоупотребляйте плотностью ключевых слов и избегайте в них спамных конструкций.

В дополнительные результаты могут автоматически отправляться молодые сайты, со временем они попадут в основные результаты Google. Если контент на них представляет интерес для пользователей.

-5, -30 и -950

Официально в Google про этот фильтр ничего не говорили, но он есть. Характерный признак – падение позиций в выдаче на ровное количество позиций (5, 30 или 950). Наказывают за несоблюдение рекомендаций Google по созданию и продвижению сайтов, за использование клоакинга и дорвеев, редиректров JavaScript и злоупотребление не рекомендуемыми методами SEO, куда можно отнести переспам статей ключевыми словами, ссылочный спам и т.д.

Очевидно, что тяжесть наказания зависит от степени нарушений. Если они незначительные, то сайт получит -5, если все очень плохо, то будет -950. По сути, этот фильтр является аналогом Панды, отличие только в том, что Панда может опустить лишь часть страниц, а падение запросов в выдаче будет на разное количество позиций.

Способ выхода из под этого фильтра аналогичный. Найдите и устраните проблему, после чего можно написать запрос в Google на пересмотр сайта. Если все нарушения устранены, то позиции вернутся.

На самом деле, это не фильтр, а лишь составляющая поискового алгоритма, занижающая в мобильной выдаче ресурсы, у которых нет мобильной версии или адаптивной верстки. Соответствующее предупреждение можно увидеть в Google Search Console:

Если вам не нужен мобильный трафик, рекомендации Google можно игнорировать, но на самом деле, доля пользователей мобильных устройств очень большая и она неуклонно растет, поэтому сегодня на любом сайте нужно как минимум сделать адаптивную верстку.

За что еще может наказать Google?

Есть факторы, которые сложно отнести к какому-то фильтру, но за них есть наказание. Например, известно, что за появление слишком большого количества страниц или большого количества входящих ссылок, может последовать наказание. Если на сайте, на котором всего 500 страниц, появилось 10000, то Google сочтет это очень подозрительным. Аналогичная ситуация и со ссылками, хотя, теперь это является частью Пингвина. Рост должен быть естественным, постепенным.

Ресурс могут наказать за большое количество битых ссылок, тут могут занизить позиции в выдаче или убрать страницы из индекса. Наличие битых ссылок проверяйте с помощью сервисов, делайте это регулярно. Можно воспользоваться сервисом Link Checker или его аналогами.

О Песочницах

Песочницей называют фильтр (или часть алгоритма), который действует в отношении молодых сайтов. Официальных данных нет, но то, что молодые сайты с ходу не могут обойти более старых конкурентов, не вызывает никаких сомнений.

Google может дать молодому сайту высокие позиции, но потом отобрать их, поместив его в песочницу. Далее он будет смотреть на динамику развития, если все хорошо, сайт начнет расти в выдаче.

В Яндексе молодой сайт практически никогда не может сразу получить высокие позиции по конкурентным запросам. С низкочастотными запросами, по которым мало конкуренции, сроки меньше, но и тут может пройти несколько месяцев, пока позиции не выйдут в топ. Песочница в Яндексе длится от 2-3 месяцев до года, картина, когда после очередного апдейта поисковой базы трафик на сайт значительно увеличивается, характерны для Яндекса.

Поделать с песочницами поисковых систем ничего нельзя, можно лишь ускорить сроки выхода из под этого условного фильтра. Поступательное развитие сайта, регулярное добавление нового и хорошего контента, естественный прирост ссылочной массы способны значительно сократить сроки выхода из песочницы.

Наклейки на рабочий стол windows 10

Наклейки на рабочий стол windows 10 Построение графиков и эпюр в MathCad

Построение графиков и эпюр в MathCad Пенные облака в аренду Генератор пенных облаков

Пенные облака в аренду Генератор пенных облаков Шум в наушниках при подключении к колонкам

Шум в наушниках при подключении к колонкам